Добавьте в sitemap.xml правило lastmod для страниц, контент которых остался прежним с момента последней индексации. Это позволит избежать повторного сканирования этих страниц поисковым роботом. От размера краулингового бюджета зависит то, насколько быстро попадут в поисковую краулинговый бюджет выдачу нужные страницы. Если в команде есть разработчик, можно попросить его настроить выгрузку отчётов логов сервера. Это поможет узнать, на какие страницы робот заходил, а на какие — нет, какие взял в индекс, а какие — нет.

- Эти коды считаются идеальными, так как ведут бота к полезному контенту.

- Важно, чтобы структура была логичной и все необходимые документы имели входящие ссылки.

- Дублирование контента наиболее распространено в случае категорий товаров, содержащих разбиение на страницы.

- Страницы, которые должны быть в индексе, мы определяем в ScreamingFrog.

- Это способствует увеличению количества URL, которые готовы просканировать роботы.

Как посчитать краулинговый бюджет: 3 простых шага

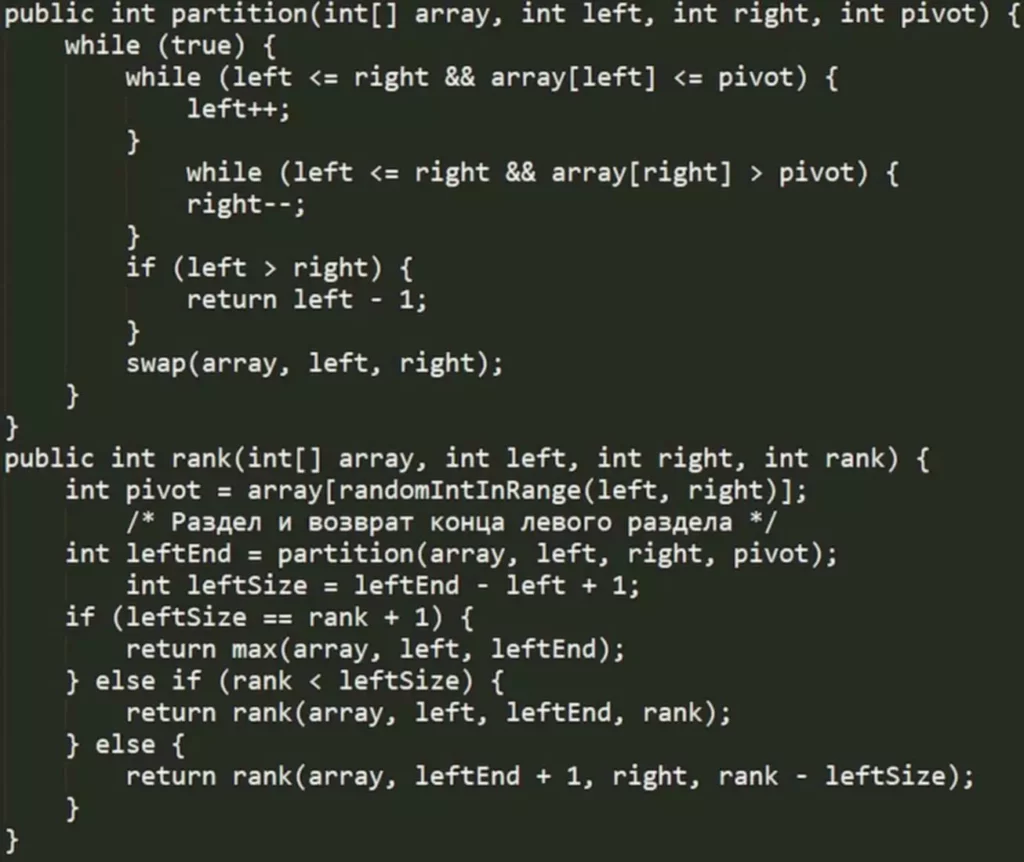

Необходимо предоставить пользователям актуальный и свежий контент, и на этой основе боты Google будут размещать страницы для индексации в соответствующей иерархии. В первой части статьи рассказывали, как посчитать краулинговый бюджет, а в этой — остановимся на советах, которые помогут предотвратить или устранить технические ошибки на сайте. Это оптимизирует краулинговый бюджет и положительно повлияет на ваши позиции в выдаче. Но при этом поисковые краулеры сами не переходят по ним и не запрашивают данные. Это помогает лучше оптимизировать все ссылки сайта, при этом сделав их недоступными для поисковых систем.

Что такое краулинговый бюджет и как его увеличить?

Краулинговый бюджет сайта определяет количество документов, которое поисковый робот должен обойти за одно посещение или другой временной промежуток. Например, если бот обходит 60 URL-адресов в сутки, то на ваш сайт выделяется 1800 страниц краулингового бюджета ежемесячно. Краулинговый бюджет (Crawl Budget) — это количество страниц сайта, которое сканирует краулер поисковых систем. После сканирования страницы, релевантные, по мнению бота, запросам пользователей, индексируются. Краулинговый бюджет (Crawl Budget) — это количество страниц сайта, которое сканирует краулер поисковых систем.

Настройте перелинковку на важные страницы сайта

Одна интерпретация предполагает, что это время, которое боты тратят на индексацию. На скрине видно, что только одна страница категорий продукта генерирует большее количество дополнительных комбинаций фильтров. А это все — неэффективный контент, который может в любую секунду попасть в индекс вместо содержимого, которое принесет бизнесу необходимую пользу.

Можно ли ограничить скорость обхода?

Во-первых, это вводит в заблуждение пользователя и раздражает его, так как он тратит свое время на поиск. Во-вторых, это приводит к трате ссылочного веса и расходу краулингового бюджета. Во время сканирования бот может найти дубли страниц — одну и ту же страницу под разными URL-адресами. Заголовок Last-Modified сообщает браузеру пользователя или роботу ПС информацию о дате и времени последнего изменения текущей страницы. Затем находим в списке показатель «Малоценная или маловостребованная страница». На проекте по продвижению интернет-магазина одежды и обуви он оказался 3,77%.

Поэтому важно знать краулинговый бюджет сайта, чтобы не допустить подобной ситуации и увеличить эффективность сканирования ботов Гугла. Краулинговый бюджет представляет собой конкретный лимит, выделяемый каждому сайту на сканирование роботом его страниц, их индексирования для формирования поисковой выдачи. Он рассчитывается для каждого веб-проекта в отдельности, исходя из доступности сервера и его спроса у пользователей. О том, зачем и как правильно настроить sitemap.xml и robots.txt мы подробно рассказывали ранее. Тщательная и грамотная проработка этих файлов важна и для целей оптимизации расхода краулингаового бюджета веб-сайта.

В первой части статьи рассказывали, как посчитать краулинговый бюджет, а в этой — остановимся на советах, которые помогут предотвратить или устранить технические ошибки на сайте. Это оптимизирует краулинговый бюджет и положительно повлияет на ваши позиции в выдаче. После того, как внесёте изменения, анализируйте, как индексируются страницы сайта, например, с помощью инструмента проверки индексации в Топвизоре. Необходимо убедиться, что в файле robots.txt открыты для индексации все нужные страницы и скрыты все лишние ссылки с помощью директив Allow и Disallow соответственно. URL обычно недостаточно, чтобы как-то влиять на краулинговый бюджет.

Второй означает, какое количество линков поисковой робот может просканировать в течение суток. Поисковик определяет для каждого сайта определенный лимит сканирования. Бюджет зависит от популярности ресурса и доступности сервера для работы бота. Оптимизация краулингового бюджета нужна, чтобы не растрачивать его впустую, а привлечь сканирующих ботов на важные и нужные разделы и страницы, исключить весь мусор из индекса. В этом посте я расскажу, что такое краулинговый бюджет, когда и почему он важен, а также поделюсь способами его оптимизировать, чтобы проиндексировать нужные страницы.

Это неплохой результат и представлен он был, в основном, битыми ссылками (код 404), которые мы впоследствии удалили. Если контент присутствует на странице, код ответа будет 200 («ОК»). Если необходима переадресация на другую страницу, код будет 301 («Перейти сюда вместо»).

К тому же, в выдачу могут попасть «мусорные» страницы, не приносящие бизнесу никакого профита. Такие страницы влияют на бюджет индексации, поскольку роботы оценивают качество URL. Краулинговый бюджет — это лимит страниц, который поисковый робот (search bot) будет проверять за определенный промежуток времени.

При добавлении заголовка ускоряется загрузка страницы и снижается нагрузка на сервер, а значит, значительно ускоряется скорость индексации страницы. Затем находим в списке показатель «Малоценная или маловостребованная страница». На проекте по продвижению интернет-магазина одежды и обуви он оказался 3,77%. Это неплохой результат и представлен он был, в основном, битыми ссылками (код 404), которые мы впоследствии удалили.

При хороших показателях увеличивается и продуктивность поискового краулера на сайте. То есть за одинаковое количество соединений бот сможет просканировать больше контента, чем если страница будет притормаживать. Это исключает двойное сканирование контента, который не менялся с тех пор, как поисковой бот сканировал страницу в последний раз.

Результаты больше зависят от количества времени, которое боты проводят на каждой странице. Склейка дублей позволила сохранить число страниц в индексе, при этом не навредить репутации сайта большим количеством неуникального контента. Дело в том, что боты Гугла не всегда могут быстро и положительно обработать содержимое на странице JavaSсript. Поэтому желательно все же использовать динамический рендеринг. При этом бот передаст запрос рендереру, а пользователь увидит обычную версию страницы.

Имея определенный лимит на сканирование страниц, бот постепенно продвигается по всем ссылкам сайта. Важно, чтобы структура была логичной и все необходимые документы имели входящие ссылки. Мы собрали наиболее часто встречающиеся вопросы, касательно краулингового бюджета сайта. Карта сайта – XML-файл, который поисковый бот посещает в первую очередь. Немного сложнее обстоят дела с 404 кодом – страница не найдена. Если возвращается 404, то это сигнал боту о том, что возможно страница появится позже, поэтому он периодически будет ее посещать.

Kommentare von fouad